Qu'est-ce que l'A/B testing ?

Vous hésitez entre deux versions d’un e-mail, d’une page Web ou d’une publicité ? L’A/B testing vous permet de les comparer et de choisir la plus performante grâce à une méthode simple et basée sur des données concrètes.

Le principe de l’A/B testing est clair : vous créez deux versions d’un même élément digital (page de destination, annonce publicitaire, e-mail marketing, publication sur les réseaux sociaux). Votre audience est ensuite divisée en deux groupes : l’un voit la “version A”, l’autre la “version B”. En mesurant un indicateur clé défini au préalable (taux de clics, inscriptions, achats, etc.), vous identifiez facilement la version qui génère les meilleurs résultats.

L’A/B testing n’est pas né avec le digital. Autrefois, le publipostage était la principale technique utilisée pour « diviser » ou « organiser » des offres afin de déterminer celle qui fonctionne le mieux. Aujourd’hui, les outils numériques permettent d’obtenir des résultats plus rapides, précis et exploitables en temps réel.

Dans un environnement où les préférences des consommateurs évoluent sans cesse, il est difficile de prédire ce qui fonctionnera le mieux. Grâce aux tests A/B, vous ne laissez plus de place à l’intuition, vous prenez des décisions basées sur des données réelles. Ce qui vous permet d’optimiser vos performances marketing et d’améliorer l’expérience utilisateur. Découvrez les bases de l’A/B testing et comment en tirer parti pour maximiser votre taux de conversion.

Définition des tests A/B : Qu’est-ce qu’un test A/B ?

Les tests A/B, également connus sous le nom de « split testing », vous permettent de comparer deux versions d’un produit ou élément pour déterminer la version la plus efficace. En d’autres termes : vos utilisateurs préfèrent-ils la version A ou la version B ?

Le concept des tests A/B est semblable à la méthode scientifique. Si vous voulez savoir ce qui se passe lorsque vous changez un seul élément, vous devez créer une situation dans laquelle seul cet élément change.

Pensez aux expériences que vous avez réalisées à l’école primaire. Si vous plantez 2 graines dans 2 pots de terre et que vous placez l’un près de la fenêtre et l’autre dans le placard, vous observerez différents résultats. Ce type de mise en place expérimentale est ce que l’on appelle un test A/B.

Historique des tests A/B

Dans les années 1960, les spécialistes du marketing se sont rendu compte que ce type de test pourrait les aider à mieux comprendre l’impact de leurs publicités. Lequel des deux générerait le plus de ventes : une publicité à la télévision ou un spot radio ? Quel support est le mieux adapté au marketing par publipostage, les lettres ou les cartes postales ?

Dans les années 1990, alors qu’Internet commençait peu à peu à faire partie intégrante du monde des affaires, les tests A/B sont eux aussi passés à la sphère numérique. Lorsque les équipes de marketing numérique ont obtenu les ressources techniques nécessaires, elles ont commencé à tester leurs stratégies en temps réel, à grande échelle.

En quoi consiste le test A/B ?

Les tests A/B impliquent l’utilisation de solutions numériques pour tester différents éléments d’une campagne marketing. Pour effectuer un test A/B, vous devez avoir :

- Une campagne à tester. Pour faire le test A/B d’une campagne marketing, vous avez besoin d’un e-mail, d’une lettre d’information, d’une annonce publicitaire, d’une landing page ou d’un autre support déjà en cours d’utilisation.

- Éléments à tester. En examinant les différents éléments de votre campagne, réfléchissez à ce que vous pouvez changer et ce qui peut inciter les clients à agir. Assurez-vous de tester les éléments individuellement pour vous assurer d’obtenir des mesures correctes.

- Objectifs définis. Vos tests A/B doivent déterminer quelle version de votre campagne offrent de meilleurs résultats pour votre entreprise. Réfléchissez aux différents éléments que vous pouvez mesurer, y compris les clics, les inscriptions ou les achats.

À quoi ressemblent les tests A/B à l’ère du numérique ?

En substance, les tests A/B n’ont pas changé. Vous choisissez le facteur que vous souhaitez analyser, comme un article de blog avec des images et ce même article sans les images. Ensuite, vous affichez aléatoirement un des deux articles de blog auprès des visiteurs, tout en contrôlant d’autres facteurs. Vous enregistrez également autant de données que possible, notamment sur les taux de rebond, le temps passé sur la page, et ainsi de suite.

Vous pouvez même tester plusieurs variables à la fois. Par exemple, si vous souhaitez évaluer la police ainsi que la présence ou l’absence d’images, vous pouvez choisir de créer 4 pages différentes, chacune affichant le même article de blog avec une particularité :

- Arial avec images

- Arial sans images

- Times New Roman avec images

- Times New Roman sans images

Un logiciel de test A/B renvoie les données provenant d’expériences telles que celles-ci. Un de vos collaborateurs interprète ensuite les résultats pour décider si votre entreprise doit prendre une décision en fonction de ces données et dans quelle mesure, le cas échéant.

Pourquoi les tests A/B sont-ils importants ?

Les tests A/B vous fournissent les données nécessaires pour optimiser votre budget marketing. Supposons que votre responsable vous a donné un budget pour générer du trafic vers le site Web de votre entreprise en utilisant Google AdWords. Vous configurez un test A/B qui suit le nombre de clics sur trois titres d’articles différents. Vous exécutez le test pendant une semaine, en vous assurant d’utiliser le même nombre d’annonces pour chaque option à tout moment.

Les résultats de ce test vous aideront à déterminer quel titre génère le plus de clics. Vous pouvez alors utiliser ces données pour créer votre campagne marketing en conséquence, ce qui vous permettra d’obtenir un retour sur investissement (ROI) plus élevé que si vous vous étiez contenté de choisir un titre au hasard.

De petits changements pour de grandes améliorations

Les tests A/B vous permettent d’évaluer l’impact de changements relativement peu coûteux à mettre en œuvre. L’exécution d’une campagne AdWords demande un budget conséquent ; vous voulez donc que chaque aspect soit aussi efficace que possible.

Imaginons que vous exécutez un test A/B sur la police de votre page d’accueil, la taille du texte, les titres des menus, les liens et le positionnement de votre formulaire d’inscription personnalisé. Vous testez deux ou trois de ces éléments à la fois afin qu’il n’y ait pas trop de variables qui se recoupent.

Une fois le test terminé, vous observez que le fait d’avoir changé les trois derniers éléments augmente le taux de conversion de 6 % pour chaque élément. Votre concepteur Web implémente alors ces changements en moins d’une heure, après quoi vous aurez une chance d’obtenir 18 % de revenus supplémentaires.

Un risque maîtrisé pour de nombreux avantages

Les tests A/B sont une méthode rapide et rentable pour optimiser ses contenus et stratégies marketing. Ils permettent de comparer objectivement plusieurs versions d’un même élément et de prendre des décisions basées sur des données réelles. Il existe quelques risques à prendre en compte lorsqu’on se lance dans ce type de tests. Par exemple, effectuer un test sur une taille d’échantillon insuffisante risque de fausser les résultats et mener à prendre des décisions erronées. Parmi les autres risques possibles, on peut évoquer une durée de test trop courte, ou encore un effet de saisonnalité qui pourraient engendrer des résultats biaisés. Utiliser l’A/B testing, c’est aussi risquer de perdre temporairement en conversions, même si cela reste une étape d’optimisation.

Au-delà de certains risques, les tests A/B offrent un excellent retour sur investissement s’ils sont bien menés.

Tirer le meilleur parti du trafic

Si vous utilisez les tests A/B pour rendre votre site Web aussi efficace que possible, vous pourrez obtenir plus de conversions par visiteur. En améliorant continuellement les performances de vos pages, vous transformez davantage de visiteurs en clients, réduisant ainsi la nécessité d’investir massivement en acquisition de trafic.

Un taux de conversion plus élevé signifie que chaque visiteur a plus de chances d’effectuer une action souhaitée, qu’il s’agisse d’un achat, d’une inscription ou d’un clic sur un bouton d’appel à l’action (CTA). Cela profite autant au trafic payant qu’au trafic organique, vous permettant ainsi de rentabiliser, d’optimiser chaque source de visite et de maximiser l’impact de vos efforts marketing.

Augmentez votre taux de conversion grâce à des tests et des expérimentations stratégiques

Découvrez les principes fondamentaux de l'optimisation du taux de conversion grâce à notre guide, qui fournit des stratégies essentielles pour des tests et des expérimentations efficaces afin d'optimiser les performances de votre page Web.

Avec quels types de contenu peut-on utiliser des tests A/B ?

L’A/B testing est un outil puissant pour optimiser l’impact de vos contenus en testant différentes versions avant de faire un choix définitif. Les tests A/B peuvent être appliqués à une grande variété de supports marketing afin d’identifier ce qui fonctionne le mieux auprès de votre audience.

Les types de contenu les plus couramment testés sont :

- Campagnes par e-mail: ligne d’objet, ton du message, visuel, bouton d’appel à l’action.

- E-mails individuels ou newsletters : fréquence d’envoi, disposition des articles, contenu des sections.

- Stratégies de marketing multimédia : types de messages utilisés (génériques ou personnalisés), formats.

- Publicités payantes sur Internet : texte de l’annonce, image ou vidéo, format, ciblage.

- Conception de sites Web via l’expérience utilisateur du site Web (navigation, emplacement des boutons, design) ou des landing pages (structure, titres, formulaires, couleurs).

Dans chacune de ces catégories, vous pouvez effectuer des tests A/B avec un nombre illimité de variables. Si vous testez la conception de votre site Web, par exemple, vous pouvez essayer différentes options, notamment les suivantes :

- La palette de couleurs : y’a-t-il un impact émotionnel des couleurs sur le taux de conversion ?

- La mise en page, notamment la disposition des éléments clé pour une navigation intuitive.

- Le nombre et le type d’images.

- Les en-têtes et les sous-titres, pour tester la clarté et l’attractivité du message.

- La tarification des produits. On parle ici plutôt de l’affichage des prix, avec ou sans réduction par exemple, ou l’intégration d’une comparaison de plans.

- Des offres spéciales.

- La conception des boutons d’appel à l’action (CTA), leur formulation, couleur, forme ou taille.

Pour ce qui est des tests spécifiques aux e-mails, on peut facilement comparer des e-mails vidéo et des e-mails non-vidéo. Il est aussi possible de tester différents types de textes (personnalisés ou génériques). Par exemple, l’ajout du prénom de l’utilisateur influence-t-il l’ouverture du mail ?

Même si tous les éléments de style, de contenu ou d'interaction peuvent être testés, il est important de ne pas tester trop de variables en même temps. Il est conseillé de ne tester qu’une seule variable à la fois afin d’obtenir des résultats clairs et exploitables.

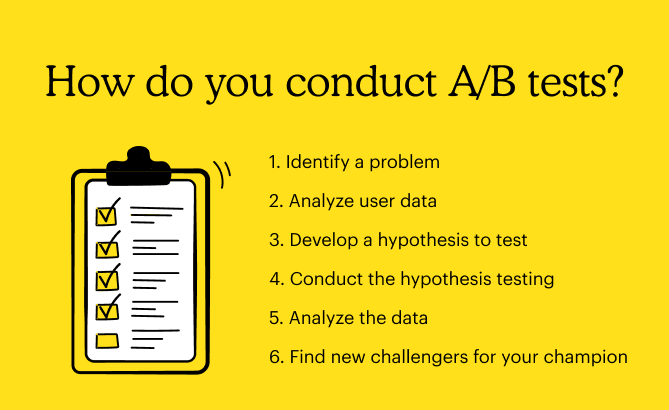

Comment effectuer des tests A/B ?

En fin de compte, le processus de test A/B n’est ni plus ni moins que la méthode suivie par les scientifiques. Si vous voulez tirer le meilleur parti de ce processus, vous devez l’aborder de manière scientifique. Tout comme pour la méthode scientifique utilisée en laboratoire, la première étape d’un test A/B consiste à déterminer l’objet du test. Le processus dans son ensemble est divisé en plusieurs étapes :

1. Identifier un problème

Assurez-vous d’identifier un problème spécifique. Par exemple, « Mon nombre de conversions est insuffisant » serait trop général. Bien trop de facteurs entrent en jeu pour déterminer si une personne visitant votre site Web deviendra un client ou si le destinataire d’un de vos e-mails cliquera sur le lien de votre site Web. Vous devez savoir pourquoi votre contenu ne génère pas de conversions.

Exemple : Vous travaillez pour un magasin de vêtements pour femmes qui génère de nombreuses ventes en ligne, mais très peu de ces ventes proviennent des campagnes par e-mail du magasin. En consultant vos données analytiques, vous constatez qu’un pourcentage élevé d’utilisateurs ouvrent vos e-mails concernant des offres spéciales et les lisent, mais que peu d’entre eux passent à l’étape suivante.

2. Analyser les données des utilisateurs

Techniquement, vous pourriez effectuer des tests A/B sur tout ce que vos clients voient quand ils ouvrent vos e-mails, mais cela prendrait un temps considérable. Parmi la multitude d’éléments de conception et de contenu qui s’affichent sur leur écran, bon nombre d’entre eux ne sont pas pertinents ; il vous faut donc déterminer l’élément qui doit être ciblé en priorité.

Exemple : Les destinataires ouvrent bien vos e-mails, il n’y a donc aucun problème apparent avec la manière dont vous rédigez vos lignes d’objet. Ils passent également du temps à les lire, rien ne les rebute donc de but en blanc. Étant donné qu’une grande partie des utilisateurs qui trouvent l’adresse de votre site Web sur des supports tiers finissent par devenir des clients, vous pouvez supposer qu’il n’y a aucun problème avec la façon dont vous présentez vos produits. Cela suggère que, bien que les gens trouvent vos e-mails attrayants, ils abandonnent à mi-parcours avant de cliquer sur le lien de votre site Web.

3. Formuler une hypothèse à tester

Vous avez maintenant considérablement réduit le champ des possibilités. La prochaine étape consiste à déterminer exactement les éléments que vous souhaitez tester et la façon dont vous comptez procéder. Réduisez le nombre d’inconnues pour n’en garder qu’une ou deux, du moins pour commencer. Ensuite, vous pouvez déterminer la mesure dans laquelle le fait de modifier ce ou ces éléments pourrait vous permettre de résoudre le problème que vous rencontrez.

Exemple : Vous remarquez que le bouton de lien vers votre boutique en ligne est situé en bas de l’e-mail, sous le pli. Vous vous dites qu’en insérant le bouton en haut de la page, vous aurez peut-être plus de chance que les gens consultent votre site Web.

4. Vérifier votre hypothèse

Créez une nouvelle version de l’élément de test qui met en œuvre votre hypothèse. Ensuite, exécutez un test A/B entre votre page actuelle et cette nouvelle version auprès de votre audience cible.

Exemple : Vous créez une version de l’e-mail en plaçant le bouton au-dessus du pli, Vous ne changez pas sa conception, juste son positionnement. Vous décidez d’exécuter le test pendant 24 heures. Vous définissez alors cet intervalle comme paramètre temporel et lancez le test.

5. Analyser les données

Une fois le test terminé, analysez les résultats pour vérifier si la nouvelle conception de l’e-mail a entraîné des changements notables. Si ce n’est pas le cas, essayez de tester un nouvel élément.

Exemple : Votre nouvel e-mail a légèrement augmenté le taux de conversions, mais votre responsable veut savoir si quelque chose d’autre pourrait donner de meilleurs résultats. Puisque votre variable était le positionnement du bouton, vous décidez de le placer dans deux autres endroits.

6. Trouver de nouveaux challengers pour votre championne.

Dans le monde des tests A/B, on utilise parfois les termes « championne » et « challenger » pour se référer à l’option actuelle et aux nouvelles possibilités. Lorsque deux options ou plus sont mises sur le banc d’essai et que l’une d’entre elles s’avère nettement plus efficace, celle-ci est alors appelée « championne ». Vous pouvez ensuite tester cette championne par rapport à d’autres options, appelées « challengers ». Ce test pourrait dévoiler une nouvelle championne, ou révéler que la championne d’origine était réellement la meilleure option.

Exemple : Vous avez effectué un test A/B portant sur deux versions d’une page de destination et avez identifié la championne, mais il existe également une troisième version de la page que vous souhaitez comparer à la championne de votre premier test. La troisième version devient ainsi le nouveau challenger à tester par rapport à la championne du test précédent.

Après avoir suivi les six étapes décrites ci-dessus, vous pourrez déterminer si l’amélioration était suffisamment importante pour mettre fin au test et apporter les modifications nécessaires. Vous pouvez également exécuter un autre test A/B pour évaluer l’impact d’un autre élément, comme la taille du bouton ou ses couleurs.

Conseils pour les spécialistes des tests A/B

Voici quelques conseils pour vous aider à rendre vos tests A/B aussi utiles que possible.

Utilisez des échantillons représentatifs de vos utilisateurs

N’importe quel scientifique vous dira que si vous préparez une expérience, vous devez vous assurer que vos groupes de participants sont aussi similaires que possible. Si vous testez un site Web, vous pouvez utiliser divers outils de test automatisé pour vous assurer que chaque version sera présentée à un groupe de personnes aléatoire.

Si vous envoyez les versions directement à vos clients ou prospects, vous devrez créer manuellement des listes comparables. Faites en sorte que les groupes soient de taille aussi égale que possible, et si vous avez accès aux données, répartissez les destinataires de manière égale en fonction du sexe, de l’âge et de la région. Ainsi, toute variation de ces facteurs aura un impact minimal sur vos résultats.

Utilisez les plus grands échantillons possible

Plus le nombre de personnes testées est grand, plus vos résultats seront fiables. Cela est lié à un concept que les statisticiens appellent la « pertinence statistique ».

En somme, si le résultat est pertinent sur le plan statistique, cela signifie qu’il est peu probable qu’il soit dû au hasard. Par exemple, si vous envoyez une nouvelle version d’un e-mail à 50 personnes et la version de contrôle à 50 personnes, une augmentation de seulement 5 % du taux de clic signifie que 5 personnes ont été plus sensibles à votre nouvelle version. La différence est si minime qu’elle pourrait être due au hasard ; et si vous effectuez à nouveau le même test, il est possible que vous obteniez des résultats différents. En d’autres termes, vos résultats n’ont pas été pertinents sur le plan statistique.

Si vous avez la possibilité d’envoyer le même ensemble d’e-mails à des groupes de 500 personnes, une augmentation de 5 % signifierait que 50 personnes ont été plus sensibles à la nouvelle version, soit un résultat beaucoup plus susceptible de s’avérer pertinent.

Évitez les erreurs courantes

Il est tentant de créer un bouton contextuel de taille différente avec une nouvelle police, une nouvelle taille de texte et de nouvelles couleurs. Cependant, plus vous ajoutez de nouveaux éléments, plus vos résultats seront imprécis.

Pour poursuivre l’exemple donné ci-dessus, si la conception de votre nouveau bouton contextuel est complètement différente de l’originale, vous observerez probablement des corrélations entièrement fortuites. Peut-être semble-t-il que le grand bouton violet « Passer à la caisse » avec l’image du signe dollar fonctionne mieux que le petit bouton bleu qu’il a remplacé. Cependant, il est possible qu’un seul de ces éléments de conception soit significatif, comme la taille, par exemple.

N’oubliez pas que vous pourrez toujours exécuter un nouveau test avec d’autres éléments plus tard. Ce test de suivi sera plus facile à analyser qu’un test qui comporte 18 variables.

Attendez la fin du test avant d’apporter des modifications

L’un des pièges les plus courants en A/B testing est de tirer des conclusions trop rapidement. On peut voir une tendance émerger dès les premières heures ou les premiers jours, mais il ne faut pas interrompre un test trop tôt au risque de produire des résultats biaisés et non significatifs. Plus vos tests durent, plus vos résultats seront représentatifs. En effet, cela évite de donner trop d’importance aux effets des variations temporelles. Les performances peuvent fluctuer selon le jour de la semaine, l’heure ou d’autres facteurs externes (promotions, saisonnalité) ce qui peut fausser les résultats de votre test. Aussi, vous pouvez observer un écart en début de test qui peut s’inverser avec le temps. Attendre la fin du test garantit alors une analyse basée sur un volume de données suffisant.

Notre astuce : définissez dès le départ une durée minimale de test en fonction de votre trafic et de votre objectif. Attendez bien la fin de la durée du test pour confirmer que vos résultats sont réellement concluants avant de prendre une décision marketing.

Exécutez plusieurs fois le même test

Le comportement des utilisateurs étant extrêmement variable, même le meilleur logiciel de test A/B n’est pas à l’abri de fournir de faux positifs. La seule façon de vous assurer que les résultats de vos tests sont précis est d’exécuter à nouveau le même test, avec les mêmes paramètres.

Cela est d’autant plus important si votre nouvelle version présente une faible marge d’amélioration. Un seul résultat faussé peut avoir une incidence considérable si les résultats positifs sont peu nombreux.

En outre, si vous exécutez de nombreux tests A/B, il est plus probable que vous rencontriez un faux positif de temps à autre. Vous ne pourrez peut-être pas vous permettre de relancer tous les tests à la fois, mais en effectuant un nouveau test de temps en temps, vous aurez plus de chances d’identifier des erreurs.

Simplifiez les tests A/B avec Mailchimp

Les tests A/B sont un moyen efficace d’évaluer la réaction de votre audience face à une conception ou une idée de contenu, car ils ne perturbent pas l’expérience de vos utilisateurs et n’exigent pas de leur envoyer des enquêtes malvenues. Essayez simplement quelque chose de nouveau et laissez les résultats parler d’eux-mêmes.

Novice en matière de tests A/B ? Testez facilement vos campagnes avec Mailchimp pour déterminer quels en-têtes d’e-mail, éléments visuels, objets et versions sont mieux accueillis par vos clients.

La FAQ de l’A/B testing

Combien de temps doit durer un test A/B ?

La durée idéale va dépendre de différents facteurs, dont votre volume de trafic et de l’objectif du test. En général, l’A/B testing doit durer au minimum deux semaines pour obtenir des résultats fiables et ne doit pas dépasser 1 mois.

Comment savoir si mon test A/B est concluant ?

On conclut qu’un test est réussi si une des versions obtient une performance significativement supérieure sur l’indicateur suivi (taux de clics, conversions). Vous pouvez utiliser un outil d’analyse pour vérifier que la différence est statistiquement significative et non due au hasard.

A/B testing : peut-on tester plusieurs éléments à la fois ?

Oui, cela s’appelle un test multivarié. Contrairement à un A/B test classique qui va permettre de comparer deux versions d’un même élément, un test multivarié analyse plusieurs combinaisons de modifications en simultané. Attention cependant, car c’est une technique plus complexe à mettre en place.

L’A/B testing fonctionne-t-il pour tous les types d’entreprises ?

Oui ! Que vous soyez une startup, une boutique e-commerce ou une grande entreprise, les tests A/B vous aident à optimiser votre communication et vos conversions. Vous pouvez l’utiliser quel que soit votre secteur d’activité et sans compétences en développement. Seule une connaissance de base en analyse de données est utile pour interpréter correctement les résultats et optimiser vos campagnes.